我急切地想知道,于是打开了某度,但是一搜全是很鸡肋的信息,很多软件也没啥实际用处,浪费了时间还找不到答案,气坏了我们这些热锅上的蚂蚁。

我急切地想知道,于是打开了某度,但是一搜全是很鸡肋的信息,很多软件也没啥实际用处,浪费了时间还找不到答案,气坏了我们这些热锅上的蚂蚁。

但是仔细剖析这个问题,冷静思考之后我想到了几个很有价值的思考点,这么多年的工作经验,也让我有了一定的心得体会,接下来就系统地和各位讲明白。

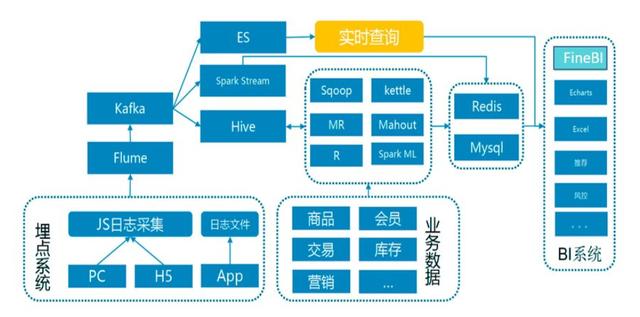

在数据分析师的工作中,报表制作是频率很高的一项工作内容。成熟的公司中,通常已有数据产品或BI工具来帮助分析师完成报表类型的工作,而且对于需要外源数据(这里指非数据库中的存储数据)更新或是业务变动较快的业务来说,实时更新的数据BI工具就显得尤为重要了。

如果你只做数据分析,全平台全方位的数据,根据目前所接触到的,EXCEL已不足够支撑,而且很快就会被淘汰。如果你要做拖拽重计算之类的,或者是商务智能的,你可以用BI工具,BI工具有许多,下面再接着介绍。

但是仔细剖析这个问题,冷静思考之后我想到了几个很有价值的思考点,这么多年的工作经验,也让我有了一定的心得体会,接下来就系统地和各位讲明白。

在数据分析师的工作中,报表制作是频率很高的一项工作内容。成熟的公司中,通常已有数据产品或BI工具来帮助分析师完成报表类型的工作,而且对于需要外源数据(这里指非数据库中的存储数据)更新或是业务变动较快的业务来说,实时更新的数据BI工具就显得尤为重要了。

如果你只做数据分析,全平台全方位的数据,根据目前所接触到的,EXCEL已不足够支撑,而且很快就会被淘汰。如果你要做拖拽重计算之类的,或者是商务智能的,你可以用BI工具,BI工具有许多,下面再接着介绍。

简单来说,我们可以把大数据分析工具简单分成两个维度:

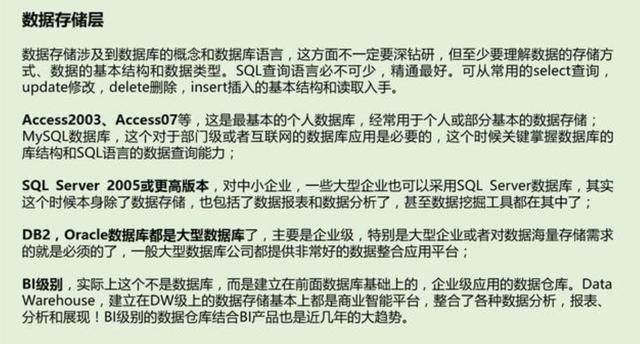

第一维度:数据存储层——数据处理层——数据报表层——数据分析与展现层

第二维度:用户级——部门级——企业级

简单来说,我们可以把大数据分析工具简单分成两个维度:

第一维度:数据存储层——数据处理层——数据报表层——数据分析与展现层

第二维度:用户级——部门级——企业级

先从第一维度说起吧。

先从第一维度说起吧。

具体的,就是一些数据库的使用,不要说这方面的知识不想学,有运维替你管着。

一个好的大数据体系,数据仓库和数据库、数据湖、数据集市的建立是非常重要的,建模的维度就决定了你后面分析的维度,如果维度不够全面与准确,那你的工具再好也就没有意义了。

具体的,就是一些数据库的使用,不要说这方面的知识不想学,有运维替你管着。

一个好的大数据体系,数据仓库和数据库、数据湖、数据集市的建立是非常重要的,建模的维度就决定了你后面分析的维度,如果维度不够全面与准确,那你的工具再好也就没有意义了。

还有一些可以数据抓取的工具,我就不说了,本质其实都差不多。

还有一些可以数据抓取的工具,我就不说了,本质其实都差不多。

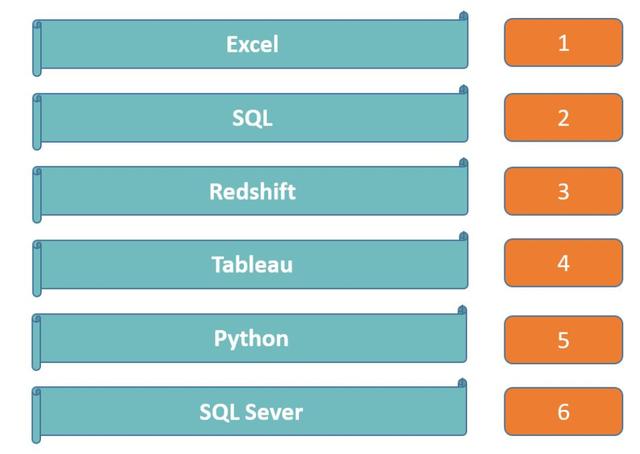

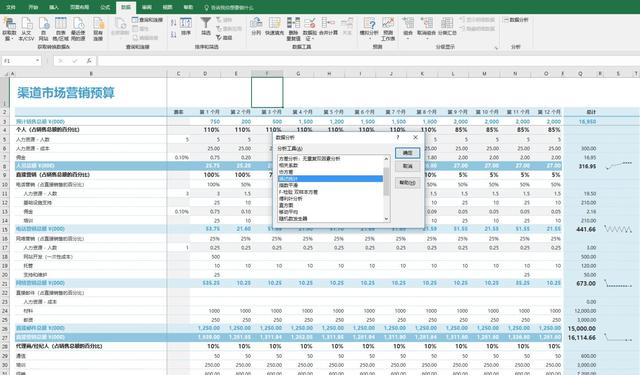

不信?你随便去问问500人以上的公司,Excel行不行,这样的公司可能有千万家,但最后得出的结论都是一致的:

Excel会导致企业信息化程度不够

数据口径不一致,浪费人力去核对

数据采集困难,更改不能实时显示数据

不信?你随便去问问500人以上的公司,Excel行不行,这样的公司可能有千万家,但最后得出的结论都是一致的:

Excel会导致企业信息化程度不够

数据口径不一致,浪费人力去核对

数据采集困难,更改不能实时显示数据

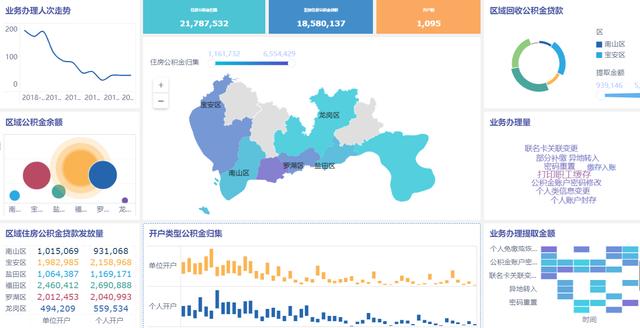

FineReport做的可视化

关于报表工具,我认可的只有FineReport,《我月薪3W,却不用熬夜加班做报表,这个养老工具,你一定要知道》,这里就不再过多介绍。 这才是真正的大数据分析工具,别被忽悠了!

你是可以直连数据库的,它支持很多种不同类型的数据库,哪怕是不同的数据源,也可以在一起分析!

这才是真正的大数据分析工具,别被忽悠了!

你是可以直连数据库的,它支持很多种不同类型的数据库,哪怕是不同的数据源,也可以在一起分析!

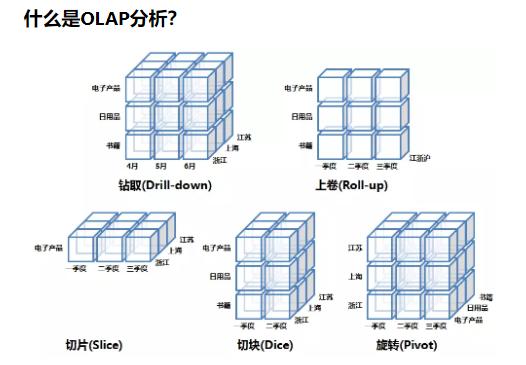

谈到BI,就不得不谈一下OLAP技术,老一代OLAP分析的技术实现需要严格的从头开始手动建模,Cube的大小极大限制了大数据背景下的使用场景,动辄成百上千新旧不一的Cube需要繁重的运维,架构无法纵向扩展、无法满足大数据量下构建、查询和并发的性能要求。

谈到BI,就不得不谈一下OLAP技术,老一代OLAP分析的技术实现需要严格的从头开始手动建模,Cube的大小极大限制了大数据背景下的使用场景,动辄成百上千新旧不一的Cube需要繁重的运维,架构无法纵向扩展、无法满足大数据量下构建、查询和并发的性能要求。

FineBI的数据业务包是BI分析的数据基础,由管理员创建,通过定义的数据连接向数据库中取数,获取到的数据自动保存在Cube中,BI分析则从Cube中获取数据,这也就保证了只要Cube中存有数据,就算不联网也可以使用BI分析。

所以现在懂了吗?数据实时显示,FineBI就是这么完成的。

其实数据展现类的工具,靠不靠谱还得看引擎,FineBI引擎的两种模式完美支持大数据量分析,在特定的场景下,如银行、电商,可以做到亿级数据的秒级呈现。

抽取模式:提供基于索引的高效计算引擎,通过数据预加载,支撑前端快速数据分析,适用于实时性要求不高的分析。

实时模式:直接对接读取企业的数据库表进行分析,适用于对实时性要求较高的数据分析场景。

FineBI的数据业务包是BI分析的数据基础,由管理员创建,通过定义的数据连接向数据库中取数,获取到的数据自动保存在Cube中,BI分析则从Cube中获取数据,这也就保证了只要Cube中存有数据,就算不联网也可以使用BI分析。

所以现在懂了吗?数据实时显示,FineBI就是这么完成的。

其实数据展现类的工具,靠不靠谱还得看引擎,FineBI引擎的两种模式完美支持大数据量分析,在特定的场景下,如银行、电商,可以做到亿级数据的秒级呈现。

抽取模式:提供基于索引的高效计算引擎,通过数据预加载,支撑前端快速数据分析,适用于实时性要求不高的分析。

实时模式:直接对接读取企业的数据库表进行分析,适用于对实时性要求较高的数据分析场景。

你不要以为FineBI是给IT、开发人员用的,它的设计模式,就是简单易用,目标是业务人员,不用再经历提交需求——等到好久才拿到报告——不满意再改——又是无尽的等待...

IT帮你初步处理好数据之后,你就可以按照自己的分析规划,将数据拖入到需要分析的维度上,对了,FineBI还具有ETL的功能,内置的数据处理计算,不需要你写函数,也是封装好的功能。

你不要以为FineBI是给IT、开发人员用的,它的设计模式,就是简单易用,目标是业务人员,不用再经历提交需求——等到好久才拿到报告——不满意再改——又是无尽的等待...

IT帮你初步处理好数据之后,你就可以按照自己的分析规划,将数据拖入到需要分析的维度上,对了,FineBI还具有ETL的功能,内置的数据处理计算,不需要你写函数,也是封装好的功能。

最后来说说FineBI的可视化效果吧,这也是很多领导看重的。

最后来说说FineBI的可视化效果吧,这也是很多领导看重的。

很显然在目前的信息时代,借助类似于FineBI的这些工具,可以让企业加速融入企业数据分析的趋势。备受市场认可的软件其实有很多,选择时必须要结合实际的情况。一般的情况下,都建议选择市面上较主流的产品,比较容易达到好的效果,目前企业数据分析BI软件市场占有率前列的,就是帆软BI软件——FineBI。

通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。

整合了MES、ERP、SQS、APS、PLM等系统,建立了公司级别的数据仓库,统一数据源,统一数据分析出口。

FineDataLink和6节点的FineData相结合,自动把4个厂的MES、ERP、WMS、PLM等业务系统,通过数据库logminer、消息等进行实时采集同步;通过对ODS层的数据加工作转换进行分层建设,完成分布式数仓的搭建,10分钟内即可完成从业务库,到ODS的ELT的整个数据链条处理。