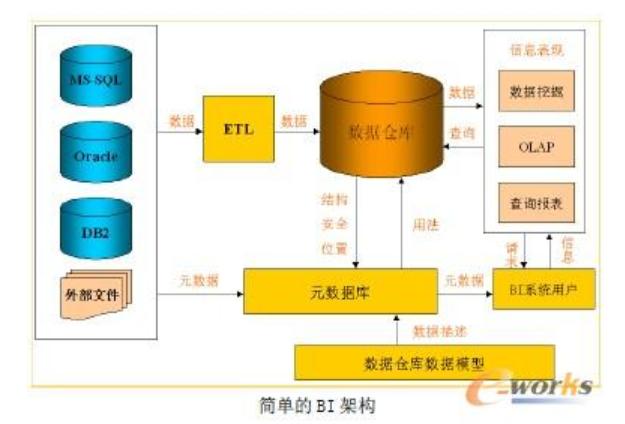

更为关键的传统商业智能的流程就是这样设计的,以IT为中心的预定义报表平台。那业务人员干啥?业务人员不可能不分析,但所谓的分析就是一起Excel一起high。要是把Excel用到极致、玩到奔溃也搞不定怎么办?

就只能把需求提给专业的IT人员进行预定义报表开发了,之后往往需要通过数周到数月的等待才能拿到一份不置可否的报表,接下去因为数据源头受限,可以做的进一步分析也十分有限。

在区块链“去中心化”理论风靡的今天,传统商业智能的中心化设计思想真是显得弱爆了,不但在为企业创造价值问题上难以自圆其说,还造成了数据可获得性、开发效率低下、“表哥表姐”等问题。

第二是普通报表工具又慢限制又多,专业工具学习又难学又难用。 Excel是业务团队中大多数“表哥表姐”的必备工具,一个神存在,其灵活性无人可及,易用性高山仰止。但是如果你用的多,也一定会知道在很多场景下,它真的不够。

比如大数据量、多数据接口、复杂数据处理、数据刷新问题、权限控制问题、可视化展现效果、数据交互能力、数据安全性等等。其中最最头疼的是性能问题,vlookup这样的计算在10万条数据就很慢了,很多时候甚至会把电脑跑崩。

而10万条数据,对于数据分析而言,实在是很小的数据量。用Excel做报表,尽管可以搭建模板,但是整理原始数据这类的工作,还是每次都要重复,最后做一张常规的周期性报表动辄数小时的工作量也十分平常。

因此,对于数据分析和报表工作来说专业工具确实是需要的,那大多数传统的专业工具又是怎样的呢?

更为关键的传统商业智能的流程就是这样设计的,以IT为中心的预定义报表平台。那业务人员干啥?业务人员不可能不分析,但所谓的分析就是一起Excel一起high。要是把Excel用到极致、玩到奔溃也搞不定怎么办?

就只能把需求提给专业的IT人员进行预定义报表开发了,之后往往需要通过数周到数月的等待才能拿到一份不置可否的报表,接下去因为数据源头受限,可以做的进一步分析也十分有限。

在区块链“去中心化”理论风靡的今天,传统商业智能的中心化设计思想真是显得弱爆了,不但在为企业创造价值问题上难以自圆其说,还造成了数据可获得性、开发效率低下、“表哥表姐”等问题。

第二是普通报表工具又慢限制又多,专业工具学习又难学又难用。 Excel是业务团队中大多数“表哥表姐”的必备工具,一个神存在,其灵活性无人可及,易用性高山仰止。但是如果你用的多,也一定会知道在很多场景下,它真的不够。

比如大数据量、多数据接口、复杂数据处理、数据刷新问题、权限控制问题、可视化展现效果、数据交互能力、数据安全性等等。其中最最头疼的是性能问题,vlookup这样的计算在10万条数据就很慢了,很多时候甚至会把电脑跑崩。

而10万条数据,对于数据分析而言,实在是很小的数据量。用Excel做报表,尽管可以搭建模板,但是整理原始数据这类的工作,还是每次都要重复,最后做一张常规的周期性报表动辄数小时的工作量也十分平常。

因此,对于数据分析和报表工作来说专业工具确实是需要的,那大多数传统的专业工具又是怎样的呢?

还有一些报表则是他们上任以后,某一次领导突发奇想要求的,一旦开始做了,就停不下来了。 至于报表的样式,对于那些老的报表来说是历史遗留,不敢去改的(也许是领导要求的?),新的报表,为了满足所有人需要,也不敢拉下每一条细节的数据,顶多是前面加一些表格统计给领导看罢了。

一张销售主题的报表,因为频率不同、范围不同、样式不同、粒度不同、KPI多几个少几个、维度多几个少几个,最后多至上百个版本。企业里铺天盖地同类型报表,除了这些报表,还要解释各个报表的差异是如何造成的,于是乎比对数据又成了另一些“表哥表姐”的工作。

我很想问一句,为什么开始的时候大家都抱怨的,到后来都妥协了呢? 这一切已经上升到了企业文化的层面了吗?

还有一些报表则是他们上任以后,某一次领导突发奇想要求的,一旦开始做了,就停不下来了。 至于报表的样式,对于那些老的报表来说是历史遗留,不敢去改的(也许是领导要求的?),新的报表,为了满足所有人需要,也不敢拉下每一条细节的数据,顶多是前面加一些表格统计给领导看罢了。

一张销售主题的报表,因为频率不同、范围不同、样式不同、粒度不同、KPI多几个少几个、维度多几个少几个,最后多至上百个版本。企业里铺天盖地同类型报表,除了这些报表,还要解释各个报表的差异是如何造成的,于是乎比对数据又成了另一些“表哥表姐”的工作。

我很想问一句,为什么开始的时候大家都抱怨的,到后来都妥协了呢? 这一切已经上升到了企业文化的层面了吗?

自助分析最初从数据可视化领域开始,目前已经扩展至各个数据分析环节。一个没有任何技术背景的业务用户,只要通过简单的学习,就可以使用这些工具完成整个分析过程。 有了简单易用的工具,制作报表的效率会大大提升,业务人员就可以用更多时间进行真正的数据分析,用数据产生价值了。

第三,建立企业良好的数据分析文化人人有责。

想要摆脱“表哥表姐”的命运,一味的抱怨和等待没有用,幻想着老板明天会幡然醒悟,开始倡导真正的数据分析文化也不可能。文化的形成本来就是一个众人拾柴火焰高的过程。

当你在抱怨的时候,有没有认真的调查过天天让你痛苦的这些报表到底做给谁看?他们为什么要看?到底想看什么?怎么看最好?是否敢于对这些报表进行大型手术,让它们价值回归而不是为了做报表而做报表?

当你在等待的时候,有没有了解最新的数据分析技术已经不是十年前的落后工具时代,完全可以通过简单的自学就成为数据分析大牛。

自助分析最初从数据可视化领域开始,目前已经扩展至各个数据分析环节。一个没有任何技术背景的业务用户,只要通过简单的学习,就可以使用这些工具完成整个分析过程。 有了简单易用的工具,制作报表的效率会大大提升,业务人员就可以用更多时间进行真正的数据分析,用数据产生价值了。

第三,建立企业良好的数据分析文化人人有责。

想要摆脱“表哥表姐”的命运,一味的抱怨和等待没有用,幻想着老板明天会幡然醒悟,开始倡导真正的数据分析文化也不可能。文化的形成本来就是一个众人拾柴火焰高的过程。

当你在抱怨的时候,有没有认真的调查过天天让你痛苦的这些报表到底做给谁看?他们为什么要看?到底想看什么?怎么看最好?是否敢于对这些报表进行大型手术,让它们价值回归而不是为了做报表而做报表?

当你在等待的时候,有没有了解最新的数据分析技术已经不是十年前的落后工具时代,完全可以通过简单的自学就成为数据分析大牛。

通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。

整合了MES、ERP、SQS、APS、PLM等系统,建立了公司级别的数据仓库,统一数据源,统一数据分析出口。

FineDataLink和6节点的FineData相结合,自动把4个厂的MES、ERP、WMS、PLM等业务系统,通过数据库logminer、消息等进行实时采集同步;通过对ODS层的数据加工作转换进行分层建设,完成分布式数仓的搭建,10分钟内即可完成从业务库,到ODS的ELT的整个数据链条处理。