作者:finedatalink

发布时间:2023.8.22

阅读次数:1,179 次浏览

数据集成过程中可能存在缺失、重复或错误数据,影响了数据的完整性和准确性。应采取数据清洗、去重和校验等措施,确保数据的完整性。

不同数据源之间可能存在数据格式和定义不一致的问题,导致数据集成困难。应进行数据映射和转换,统一数据格式和定义,提高数据一致性。

数据源的可靠性对大数据分析结果有着重要影响。应建立数据源评估机制,选择可靠的数据源,并进行数据验证和校验,确保数据的可靠性。

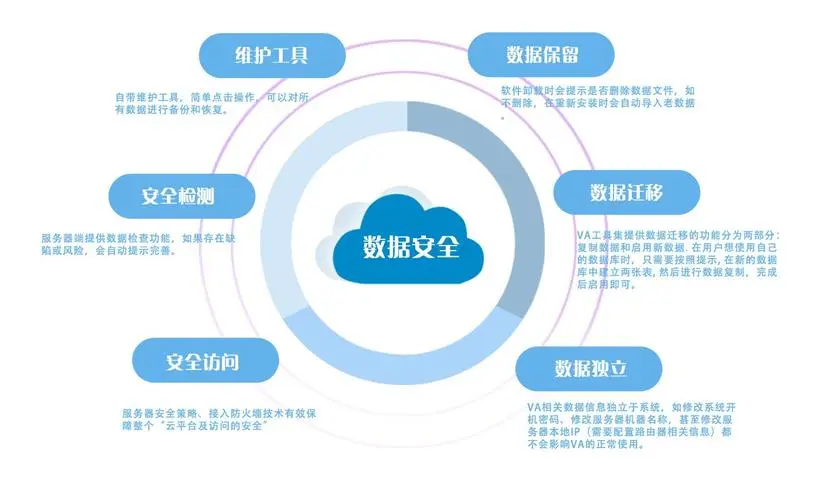

大数据处理涉及大量用户的个人隐私信息,应对数据进行有效的隐私保护措施,如数据脱敏、身份识别和权限控制等。

大数据集成和处理过程中可能面临数据泄露、篡改和攻击等安全风险。应建立完善的数据安全策略和技术架构,包括数据加密、身份认证和安全监控等。

大数据量导致存储需求巨大,数据存储成本较高。应采用数据压缩、归档和分布式存储等策略,降低存储成本。

随着数据规模的不断增长,存储系统需要具备良好的扩展性。应采用分布式存储架构,支持横向扩展和增量扩展。

大数据处理速度直接关系到分析结果的实时性和准确性。应采用并行处理、分布式计算和内存计算等技术手段,提高数据处理速度。

大数据处理过程中需要合理调度和管理不同的任务和资源。应采用任务调度工具和资源管理策略,优化任务执行顺序和资源利用率。

本文围绕大数据集成和处理过程中的挑战,从数据质量、数据安全、数据存储和处理效率四个方面进行了详细探讨,提供相应的解决策略。通过适当的规划和技术手段,可以克服这些挑战,提高大数据的价值和应用效果。

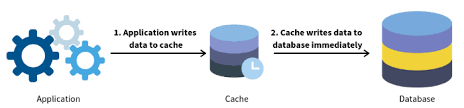

使用数据集成工具FineDataLink,可以转化不统一或质量低的数据,还可以将数据清洗和处理集中完成,将数据整合到数据仓库。减少数据连接和错误重试等繁琐的开发时间。完成数据清洗后,结果表会同步至数据库内,方便其他应用快速调用。

数据集成平台产品更多介绍:www.finedatalink.com