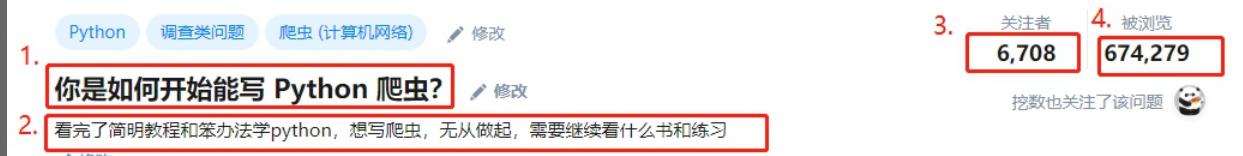

于是我使用10000秒的时间写了5000行代码,爬取了知乎下5646个话题与回答,10W+用户,和我预想的结果完全不一样。

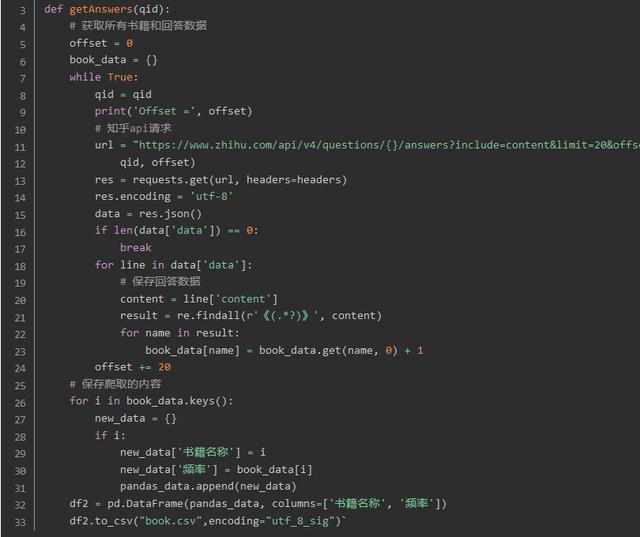

我们先放一部分代码,完整的可以到文末看评论~

于是我使用10000秒的时间写了5000行代码,爬取了知乎下5646个话题与回答,10W+用户,和我预想的结果完全不一样。

我们先放一部分代码,完整的可以到文末看评论~

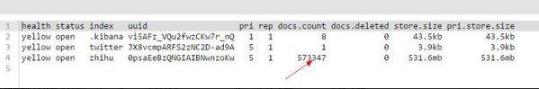

最后爬取了大概快60W的数据,我们接下来要对它进行数字可视化的分析。

最后爬取了大概快60W的数据,我们接下来要对它进行数字可视化的分析。

我们想通过数据知道什么?

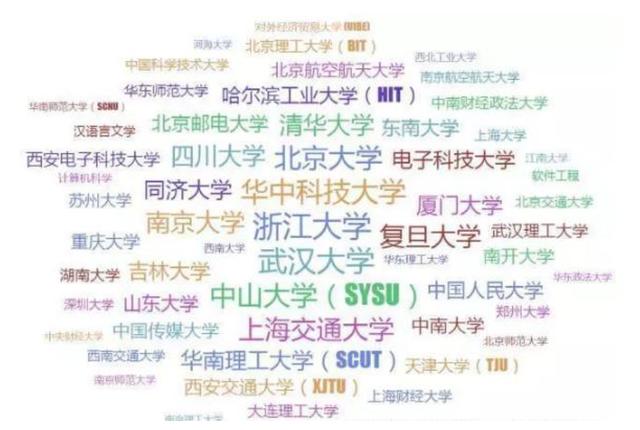

知乎人均985吗?

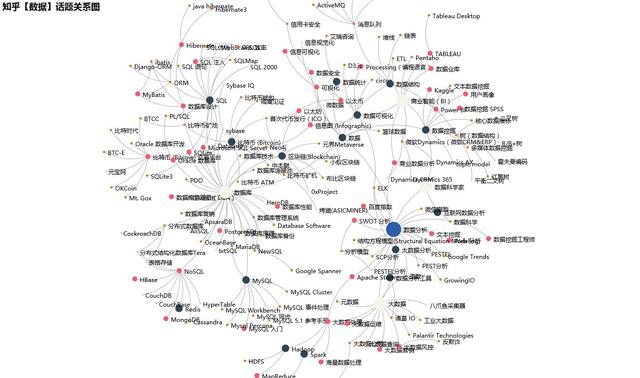

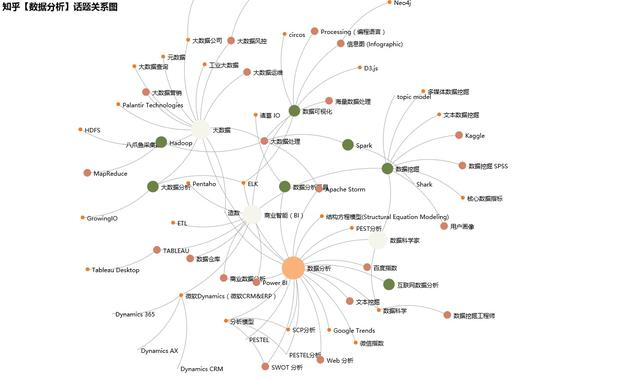

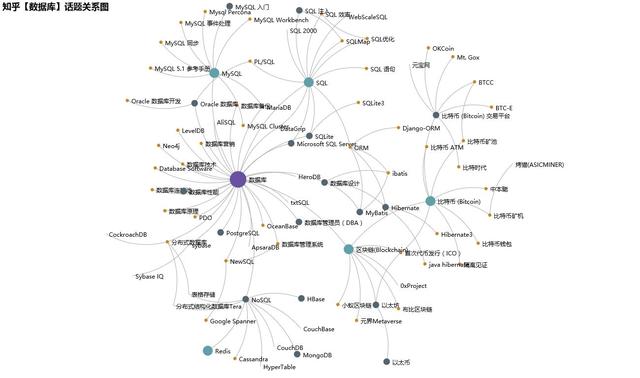

知乎最受关注的话题是哪些?这些话题的关系图谱是怎么样的?

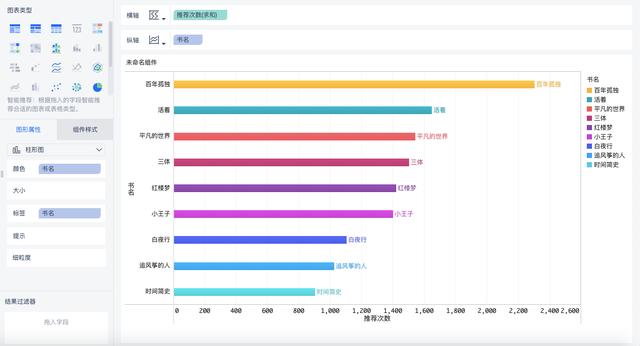

知乎大佬最推荐的书是哪些?

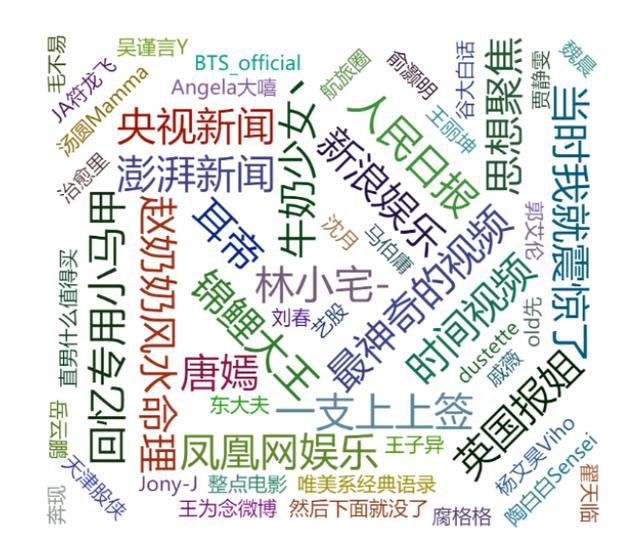

知乎的娱乐栏目最受关注的都是哪些?

在分析之前,我们得挑选一个数据可视化工具,有人会问:为什么不用python呢?因为python处理数据或许很不错,但其实它并不简单,分析起来是很困难的,SQL语句、Pandas和Matplotlib这些十分繁琐,一般人也不会。

所以我想到既然有现成数据的话,那选择一个可以直接连接数据源的工具就更好了,我想到了BI里的佼佼者FineBI,轻便敏捷的数据分析能力,浏览器里就可以直接操作,而且对于大数据量可以及时响应,直接拖拽即可生成可视化。

虽然主打的是企业级的数据分析工具,但是个人也是可以用的,而且是free的,功能并不会减少,可谓良心。很多企业依然有各种各样的数据问题:IT-业务沟通困难,领导决策缺乏数据支撑....

FineBI从IT、业务、管理层三个方面去解决问题:

我们想通过数据知道什么?

知乎人均985吗?

知乎最受关注的话题是哪些?这些话题的关系图谱是怎么样的?

知乎大佬最推荐的书是哪些?

知乎的娱乐栏目最受关注的都是哪些?

在分析之前,我们得挑选一个数据可视化工具,有人会问:为什么不用python呢?因为python处理数据或许很不错,但其实它并不简单,分析起来是很困难的,SQL语句、Pandas和Matplotlib这些十分繁琐,一般人也不会。

所以我想到既然有现成数据的话,那选择一个可以直接连接数据源的工具就更好了,我想到了BI里的佼佼者FineBI,轻便敏捷的数据分析能力,浏览器里就可以直接操作,而且对于大数据量可以及时响应,直接拖拽即可生成可视化。

虽然主打的是企业级的数据分析工具,但是个人也是可以用的,而且是free的,功能并不会减少,可谓良心。很多企业依然有各种各样的数据问题:IT-业务沟通困难,领导决策缺乏数据支撑....

FineBI从IT、业务、管理层三个方面去解决问题:

通过自助数据集功能,普通业务人员就能对数据做筛选、切割、排序、汇总等,自助灵活地达成期望的数据结果。

通过自助数据集功能,普通业务人员就能对数据做筛选、切割、排序、汇总等,自助灵活地达成期望的数据结果。

BI工具就介绍到这里,接下来我们看知乎的可视化分析,以下都是由FineBI所作。

BI工具就介绍到这里,接下来我们看知乎的可视化分析,以下都是由FineBI所作。

一看这个学校,我自卑了!!!果真人均985,211,怪不得知乎上很多回答都显得很有哲理的样子,果然,学历越高的人见识越多,看来好好学习真的很重要。不过,我说知乎的学历比虎扑高没有人反对吧。

当然,这些数据的前提都是基于你自己填写的是准确的,大专给自己填哈佛我也没办法...

一看这个学校,我自卑了!!!果真人均985,211,怪不得知乎上很多回答都显得很有哲理的样子,果然,学历越高的人见识越多,看来好好学习真的很重要。不过,我说知乎的学历比虎扑高没有人反对吧。

当然,这些数据的前提都是基于你自己填写的是准确的,大专给自己填哈佛我也没办法...

其实和微博一样,知乎也算是一个获取知识的平台,而且现在越来越多的人都把知乎当作微博来看,评论区的智商会高很多(我没有别的意思)。

一直流传着一句话:微博前脚火什么,知乎后脚扒什么...真实!

其实和微博一样,知乎也算是一个获取知识的平台,而且现在越来越多的人都把知乎当作微博来看,评论区的智商会高很多(我没有别的意思)。

一直流传着一句话:微博前脚火什么,知乎后脚扒什么...真实!

通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。通过FineDataLink作为中间件,简道云数据下云本地化,原库用于提供业务负载,本地库搭配FineReport用于数据分析展示,解决了数据分析人员无法完全取到简道云数据的问题,在FineDataLink侧进行简单的配置,同步数据和附件,即可完成简道云数据的迁移。

整合了MES、ERP、SQS、APS、PLM等系统,建立了公司级别的数据仓库,统一数据源,统一数据分析出口。

FineDataLink和6节点的FineData相结合,自动把4个厂的MES、ERP、WMS、PLM等业务系统,通过数据库logminer、消息等进行实时采集同步;通过对ODS层的数据加工作转换进行分层建设,完成分布式数仓的搭建,10分钟内即可完成从业务库,到ODS的ELT的整个数据链条处理。