作者:finedatalink

发布时间:2024.7.4

阅读次数:862 次浏览

一、数据源

用户面对大数据量的数据存储时,经常需要使用数据库的分区表功能来提高查询性能。

在Finedatalink 4.1.9版本中:定时任务、管道任务自动建表和数据服务支持选择 PostgreSQL、Greenplum、Gauss200 的分区表作为数据来源或数据去向,其中Greenplum、Gauss200支持分布逻辑,为用户提供更多选择。

分区读写支持 PostgreSQL、Greenplum、Gauss200

💠详情: 读取、创建、写入分区表

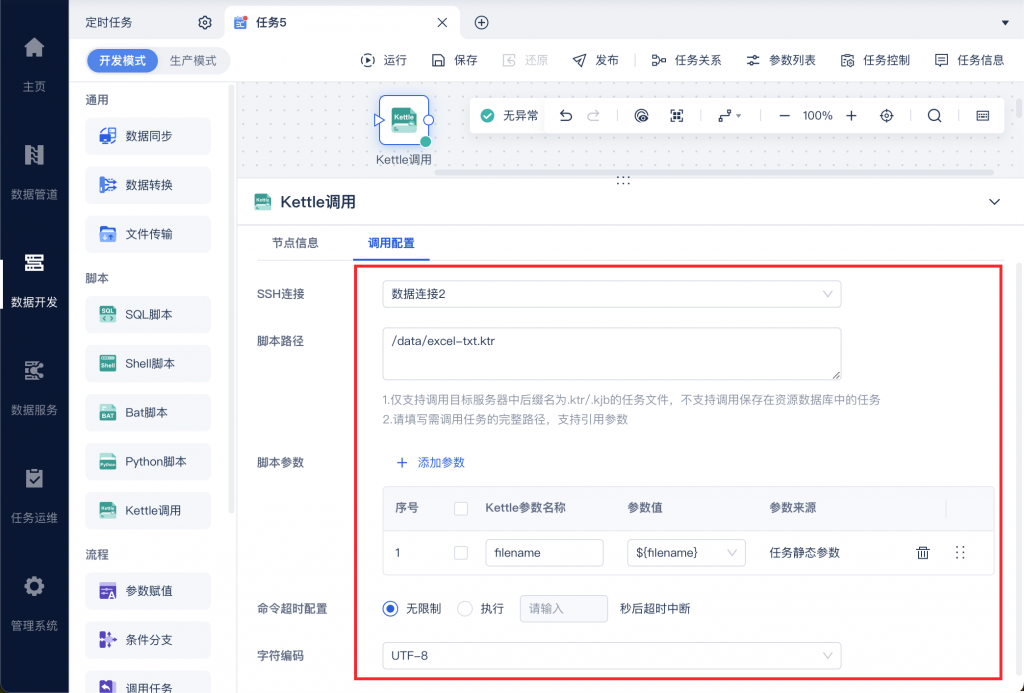

用户的历史Kettle任务可能分散在不同系统,难以统一管理和监控。

FineDataLink 4.1.9版本支持对 kettle 任务进行调用以及展示Kettle任务运行日志,帮助用户实现Kettle任务的统一管理。

Kettle调用

💠详情:Kettle调用

用户在编写SQL语句时手动输入参数易出错,且效率不高。

为了帮助用户提高开发效率,在FineDataLink 4.1.9版本中,数据开发中的:

SQL脚本、Python算子、Spark SQL算子、数据同步-API-body、API输入算子-body、DB输入算子-SQL输入框、参数赋值-DB输入SQL输入框、数据同步-DB输入SQL输入框支持自动联想参数。

SQL输入框支持联想显示参数

💠详情:SQL输入框支持联想显示参数

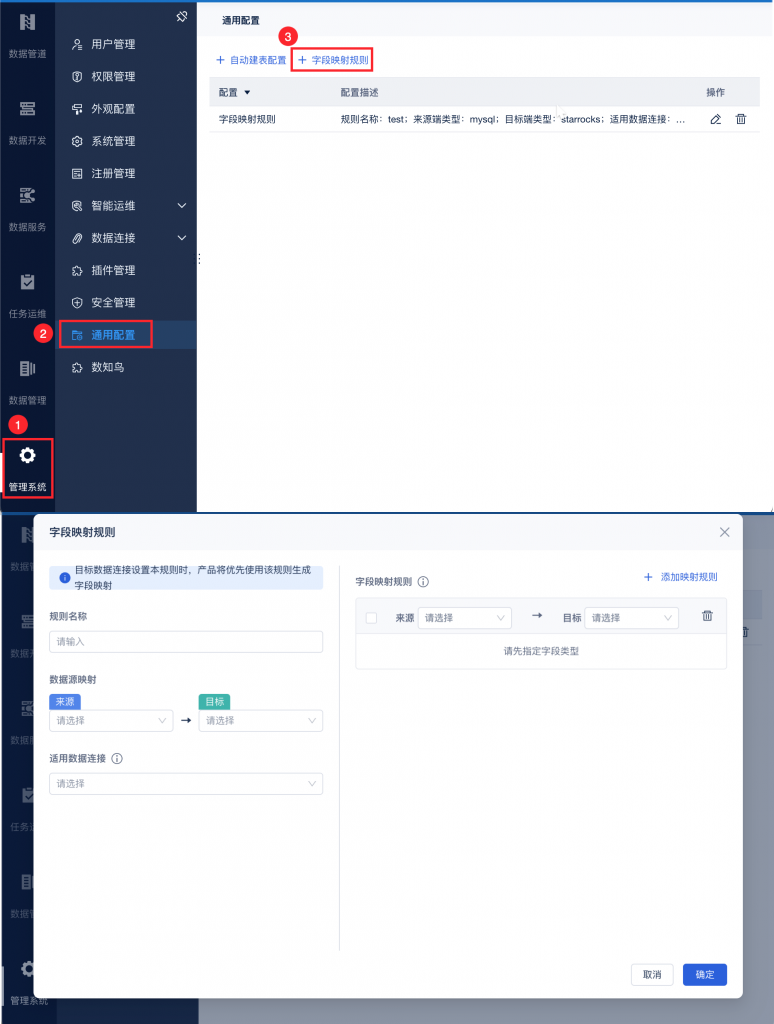

在管道任务、定时任务的同步任务配置过程中,有时会出现用户期望的字段映射关系与产品默认映射关系不符的情况。

在之前的FDL版本中,用户需要针对某个数据源下的多个任务或节点重复修改字段类型,操作非常繁琐。

为了解决这一问题,FineDataLink 4.1.9版本支持统一对多个使用同一数据连接的定时任务、管道任务自定义字段类型映射规则。

自定义字段映射规则

💠详情:通用配置-字段映射规则

用户在管理数据开发任务时,可能会误删掉重要任务,一旦删除难以恢复。

FineDataLink 4.1.9版本新增回收站功能,回收站支持对数据开发、数据管道、数据服务中已经删除的任务进行资源还原、彻底删除等。

💠详情:回收站

💠产品更新详情:4.1.9更新日志

FineDataLink是一款集实时数据同步、ELT/ETL数据处理、数据服务和系统管理于一体的数据集成工具,可在Windows或Linux环境上单机/集群部署,全程基于B/S浏览器端进行任务开发和任务运维,更多精彩功能,邀您体验,希望能帮您解决企业中数据从任意终端到任意终端的处理和传输问题,让流动的数据更有价值!

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 「产品更新」数据开发支持版本管理、实时管道支持多对一、数据源新增支持神通数据库和更高版本的Impala等!下一篇: 一文读懂CDC实时数据同步