作者:finedatalink

发布时间:2023.9.25

阅读次数:769 次浏览

随着大数据时代的到来,数据融合平台在大数据处理中扮演着至关重要的角色。然而,大规模数据的处理不仅涉及到海量数据的存储和计算,还需要考虑到数据的质量和处理效率。为了提高数据处理的性能,数据融合平台需要进行一系列的优化,下面将探讨几种常见的优化方法。

首先,优化数据存储和计算的方式是提高数据处理性能的重要手段。传统的数据库存储方式对大数据来说已经不再适用,所以可以考虑采用分布式文件系统和分布式数据库来存储数据,以提高存储能力和读写速度。同时,采用并行计算的方式可以将任务分解成多个子任务,利用多台服务器同时进行计算,从而提高整体的计算速度。

其次,合理使用缓存技术可以显著减少对底层存储系统的访问,进而提高数据处理的速度。将经常读取的数据存储在缓存中,可以大大加快后续的读取操作。此外,还可以采用分布式缓存系统,将缓存数据分散在多台服务器上,以减轻单一服务器的压力。

另外,采用合适的数据压缩算法可以有效地减少数据的存储空间,提高存储效率。不仅可以减少存储设备的开销,还可以避免了对大量数据进行频繁的读写操作,提高了数据的读写速度。同时,压缩后的数据也更便于在网络中传输,减少了数据传输的时间和成本。

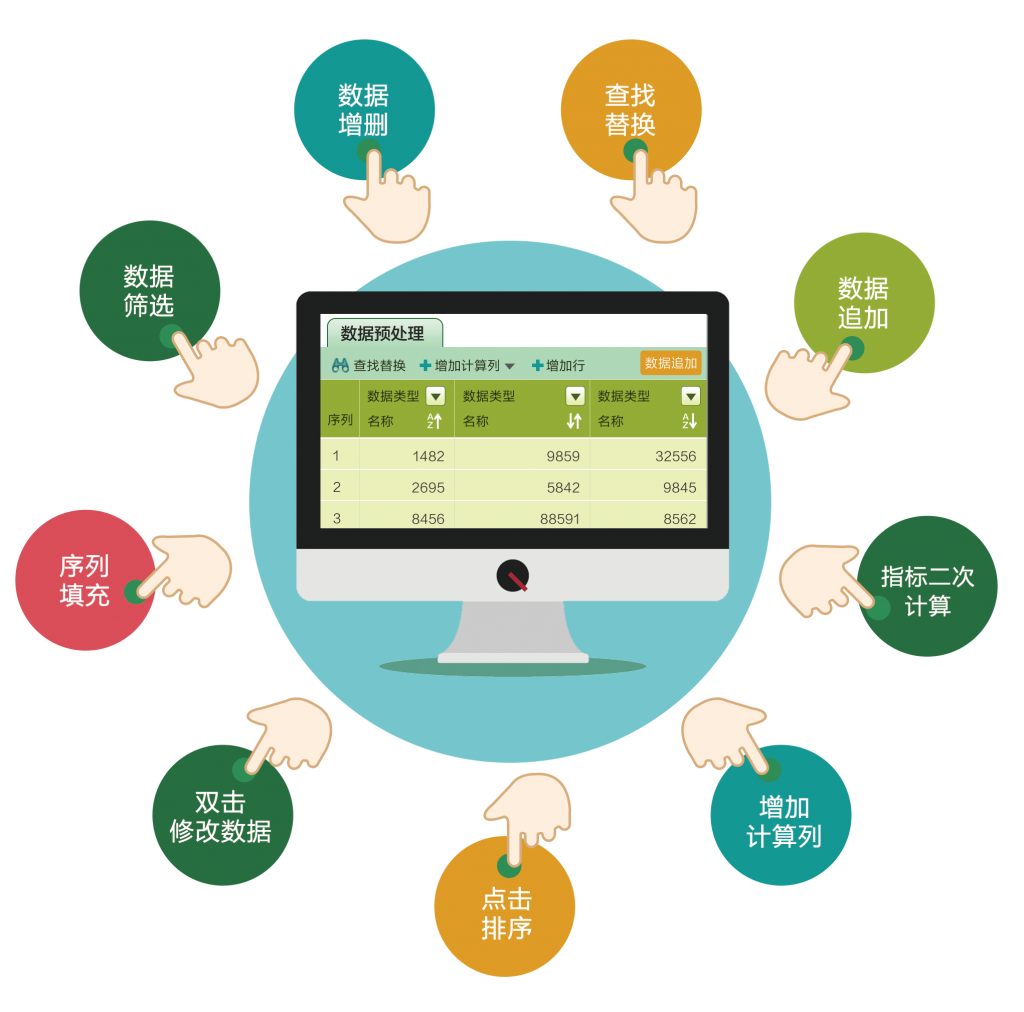

此外,优化数据清洗和预处理过程也是提高大数据处理性能的关键。在大数据处理中,往往会遇到数据质量不高、含有噪声和异常值的问题。因此,进行数据清洗和预处理工作尤为重要。可以采用并行处理和分布式计算的方式,将数据清洗和预处理工作分解成多个子任务并行执行,以提高整体的处理效率。

最后,合理使用并行计算框架和分布式任务调度系统可以进一步提升数据处理的性能。目前常用的并行计算框架有Hadoop、Spark等,它们都具有良好的可扩展性和并行计算能力。而分布式任务调度系统可以自动将任务分配给可用的计算节点执行,有效地提高调度和执行效率。

综上所述,数据融合平台在大数据处理中的性能优化是一个复杂而又关键的问题。通过优化数据存储和计算方式、合理使用缓存技术、采用数据压缩算法、优化数据清洗和预处理过程,以及使用并行计算框架和分布式任务调度系统,可以显著提高数据处理的速度和精确度。数据融合平台的性能优化不仅能够节省时间和成本,更能提高数据分析的质量和准确性,为企业决策提供更可靠的支持。

FineDataLink 是一款低代码/高时效的数据集成平台,面向用户大数据场景下,满足实时和离线数据采集、集成、管理的诉求,提供快速连接、高时效融合各种数据、灵活进行ETL数据开发的能力,帮助企业打破数据孤岛,大幅激活企业业务潜能,使数据成为生产力。

数据集成平台产品更多介绍:www.finedatalink.com

上一篇: 如何通过数据融合提升决策效率?下一篇: 数据融合技术的应用与发展趋势